「 转载请注明出处 」

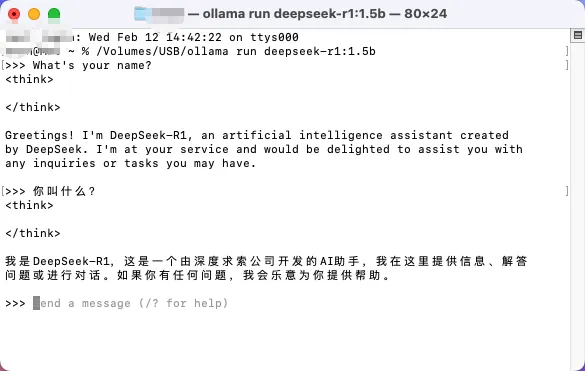

上图:deepseek 1.5b 在U盘上完美运行

如何将DeepSeek部署到U盘上,或者部署到移动硬盘上?我在思考这么做的必要性,以及它是否有具体的应用场景。先不想后面了,我们先看是否可以部署到“移动端”,这里我们选择的是U盘,这种最常见的存储介质。

一、设备和环境准备

- 硬件设备 :一台 MAC MINI M1 电脑(有macOS的电脑即可)、一个 U 盘(建议容量不小于 32GB,以确保有足够的空间存储 DeepSeek 模型文件及相关数据)。

- 软件环境 :macOS 系统(确保是最新版本,以获得最佳的兼容性和性能)、Ollama(用于运行 DeepSeek 模型)。

- 说明:此教程主要针对的是macOS用户!

二、具体部署步骤

1.安装 Ollama

- 访问 Ollama 官方网站 :在浏览器中输入https://ollama.com/,进入 Ollama 的官网。

- 下载适用于 macOS 的安装包 :在官网找到下载区域,选择适用于 macOS 系统的安装包进行下载。

- 安装 Ollama :下载完成后,双击安装包文件,按照安装向导的提示进行安装。安装过程中可能需要输入电脑的管理员密码以授权安装操作。

- 验证安装 :安装完成后,打开终端(Terminal),输入

ollama -v,如果终端显示 Ollama 的版本号,则说明安装成功。

2.下载 DeepSeek 模型

- 选择模型版本 :根据你的电脑硬件配置,选择适合的 DeepSeek 模型版本。对于 MAC MINI M1 电脑,推荐选择 DeepSeek-R1-1.5B 版本。(这里我们用最小的模型,因为只验证可行性。)

- 下载模型 :在终端中输入以下命令下载 DeepSeek-R1-1.5B 模型:

ollama pull deepseek-r1:1.5b下载过程可能需要一些时间,具体取决于你的网络速度。

3.将模型文件和 Ollama 可执行文件移动到 U 盘

- 插入 U 盘 :将 U 盘插入 MAC MINI M1 电脑的 USB 接口。

- 挂载 U 盘 :在终端中输入以下命令,挂载 U 盘(设置U 盘的盘符为 “USB”):

sudo mount -o bind /Volumes/USB /mnt - 移动模型文件 :将下载好的 DeepSeek 模型文件从默认存储位置移动到 U 盘的指定目录下。模型文件通常存储在

~/.ollama/models目录下,你可以使用以下命令将模型文件移动到 U 盘:mv ~/.ollama/models/deepseek-r1:1.5b /mnt - 复制 Ollama 可执行文件 :将 Ollama 的可执行文件复制到 U 盘中。Ollama 的可执行文件通常位于

/usr/local/bin/ollama,你可以使用以下命令将其复制到 U 盘:sudo cp /usr/local/bin/ollama /mnt - 卸载 U 盘 :在终端中输入以下命令,卸载 U 盘:

sudo umount /mnt然后安全弹出 U 盘。

注意⚠️:文件路径及U盘中的文件结构很重要,否则会导致命令无法执行。如果搞不清楚目录和文件,也可以直接找到文件复制到U盘中,这个方法不推荐,但可以解决命令无法搞定的情况。deepseek模型文件的移动更容易出现类似情况。

解决方法如下(命令没问题的,不用看。直接看步骤4):

使用 ollama pull deepseek-r1:1.5b 命令下载 DeepSeek-R1-1.5B 模型时,模型文件会被存储在以下路径:/Users/evan/.ollama/models

默认存储路径: Ollama 会将下载的模型文件存储在用户主目录下的 .ollama 文件夹中。这个文件夹通常是一个隐藏文件夹,所以在 Finder 或终端中默认不可见。

具体路径:

1. 用户主目录是 /Users/evan(假设用户名为 evan)。

2. .ollama 是 Ollama 的存储目录。

3. models 文件夹存储了所有下载的模型文件blobs和manifests。

4. 把blobs和manifests直接复制到U盘(USB)中的mnt文件夹中即可。

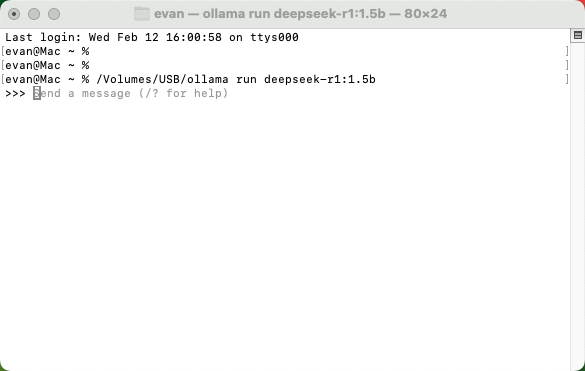

4.在其他 macOS 电脑上使用

- 插入 U 盘 :将制作好的 U 盘插入任何一台 macOS 系统的电脑的 USB 接口。

- 运行 DeepSeek :打开终端,输入以下命令运行 DeepSeek 模型:

/Volumes/USB/ollama run /Volumes/USB/deepseek-r1:1.5b模型运行后,打开浏览器,在地址栏输入http://localhost:11434,即可访问并使用 DeepSeek 模型。 - 如果运行有问题:

1. 设置环境变量 :在终端中输入以下命令,设置 Ollama 的模型路径环境变量:export OLLAMA_MODELS=/mnt

2. 运行模型 :在终端中输入以下命令运行 DeepSeek 模型:ollama run deepseek-r1:1.5b

完美运行

本文算是抛砖引玉,有兴趣深入交流可以留言或联系我。转载请注明出处!

转载或引用本站文章请注明出处

© 2024 www.evan.xin

似水流年

我没有想明白,如果制作U盘的电脑配置好,选择的是高版本的DS,制作完之后配置低的电脑能运行吗?

Evan

@似水流年 不能。u盘只是存储了deepseek和ollama,运行起了来u盘或移动硬盘的读写速度和电脑配置依然是必要条件

obaby

这都开始往 u 盘部署了,越来越离谱了

Evan

@obaby 哈哈,弄着玩。

换个好点的移动盘,可以按这个方法部署7b或8b,理论上没有问题。我没有显存,所以就部署个1.5b验证一下。

Evan

文章里面没有提及我用的U盘,我用还不是UBS口的U盘,我用的是SanDisk SDIX70N Type-C接口

Jeffer.Z

1.5B,你是魔鬼吗,它好像干不了啥。让我想起来美剧上在新生,死后灵魂可以在服务器,结果男主被女主因为成本放到了黑白色世界,然后男主的灵魂在那里思考甚至卡掉帧。

Evan

@Jeffer.Z 证明可行性,仅此而已

Jeffer.Z

@Evan 你折腾硬件,我折腾插件,一样的~

Evan

@Jeffer.Z 我不折腾了。哈哈。就是实验一下,主要是显存不行,不然上8b了

Evan

如果有兴趣玩一玩,最好选择USB 3.0及以上的U盘。不过确实1.5b版本也不需要太多的苛刻条件,这只是一个游戏,它的目的是证实部署U盘的可行性,目前的结果显而易见,但是否可以应用到具体场景中,这就是另一个问题了。